来源:中国人工智能学会

转自 CAAI会员中心

人工智能在推动经济社会创新发展的同时,也在重塑人类安全的未来。从宏观的角度来看,作为一个新技术和安全有什么样的关系?当一个新技术应用于安全时会存在如下两种情况。

一种是应用新技术服务于安全领域,我们说是新技术赋能安全领域。当然既可以服务于防御行为,利用大数据可以分析网络安全态势,这算是赋能防御;也可以服务于攻击行为,例如量子计算机的出现导致现有的密码体系失去了原有意义,这是赋能攻击。

第二种是每出现一种新技术就会带来新的安全问题,我们说这属于安全的一种伴生技术。它也有两种情况,一种是新技术本身不成熟带来了自身的安全问题,例如移动互联网的基站带来了伪基站攻击的问题,这属于内生安全;还有一种情况是新技术的问题对自身没有什么影响,但危害了其他领域,例如区块链的去中心化问题 原本属于“可控性缺失”的缺陷,其对区块链本身没有什么影响,但却挑中了中心制管理体系(如比特币就不能没收违法所得),这属于衍生安全。

人工智能赋能于安全领域

首先,人工智能可以赋能于防御。人工智能机器学习模型为积 极主动的网络防御带来了新途径。智能模型采用积极主动的方式,而不是传统的被动应对方式;同时,利用人工智能的预测能力和机器学习的进化能力,可以为我们提供抵御复杂网络威胁的手段。本质上来讲,最重要的变化是在网络攻击发生之前就进行预警并采取阻断措施。麻省理工学院研发的基于人工智能的网络安全平台AI²,用人工智能方法来分析网络攻击情况,帮助网络安全分析师做那些类似“大海捞针”的工作。AI²系统首先利用机器学习技术自主扫描数据和活动,把发现的结果反馈给网络安全分析师。网络安全分析师将会标注哪些是真正的网络攻击活动,并将工程师的反馈纳入AI²系统,从而用于对新日志的自动分析。在测试中,研究小组发现AI²的准确性约为现今所使用的自动分析工具的3倍,大大减少误报的概率。另外,AI²在分析过程中可以不断产生新模型,这意味着它可 以快速地改善自己的预测率。系统检测越多的攻击活动,收到来自分析师的反馈越多,相对地可以不断提高未来预测的准确性。据报道,AI²通过超过3.6亿行日志文件的训练,使其可以分析出85%的攻击行为,以便告警可疑行为。

其次,人工智能可以赋能网络攻击,业内称之为自动化或智能化网络攻击。通过机器人在人完全不干预的情况下,自动化地进行计算机的攻击。近年来连续发生的重大黑客事件,包括核心数据库泄密、数以亿计的账户遭入侵、WannaCry勒索病毒等都具有自动化攻击的特点。通过借助自动化工具,攻击者可以在短时间内,以更高效、更隐蔽的方式对大量不同网站进行漏洞扫描和探测,尤其对于0day/Nday漏洞的全网探测,将会更为频繁和高效。人工智能强大的数据挖掘和分析能力,以及由此带来的智能化服务,经常被黑客组织加以利用,借助于人工智能技术,形成更为拟人化和精密化的自动化攻击趋势,这类机器人模拟真人的行为会更聪明、更大胆,也更难以追踪和溯源。当前,自动化、智能化的网络攻击正在不断让网络安全防线频频失守,而这显然需要引起网络安全行业的足够重视,需要从了解自动化网络攻击行为特点入手,及时采取措施。

早在2013年,美国DARPA就发起网络超级挑战赛(Cyber Grand Challenge,CGC),旨在推进自动化网络攻防技术的发展,即实时识别系统漏洞,并自动完成打补丁和系统防御,最终实现全自动的网络安全攻防。DARPA给了104支参赛队伍以两年的时间做准备,要求他们首先开发一套全自动的网络推理系统(Cyber Reasoning System,CRS),以便依靠人工智能技术来支撑网络攻击。CRS可对主办方动态给定的挑战性程 序(Challenge Binary,CB)进行自动漏洞挖掘与补丁生成(防御),需自动生成打补丁后的加固程序(Replacement CB,RCB);需自动生成漏洞利用程序(攻击),即自动生成攻击程序(Proof of Vulnerability,PoV);需自动生成入侵检测(IDS)规则。2015年6月3日进行了初赛,24小时内,各队CRS在无人干预的情况下自动下载组织方提供的131道存在已知内存处理漏洞的CB,其共包含覆盖了53个不同类型的通用缺陷列表(Common Weakness Enumeration,CWE)的590个漏洞,CRS需要自动分析程序并查找漏洞,然后提交自动生成的RCB和PoV。比赛结果是所预留的全部漏洞都分别被不同的CRS成功的发现并修补。最终有7支队伍进入了决赛。决赛在2016年8月4日进行。决赛阶段增加了线上参赛队之间的实时对抗,并增加了网络防御能力(CRS可以自动 生成IDS规则)的评测。裁判机使用CRS提交的RCB、PoV和IDS规则,在独立、隔离环境下交叉验证(用A队的PoV攻击B队的RCB),通过综合攻击表现、防御表现、功能损失、性能损失来进行评判。最终,卡内基梅隆大学的For All Secure团队的Mayhem获得CGC冠军,进而获得人类的Defcon CTF参赛资格。在2016年8 月5-7日举办的Defcon CTF上,卡内基梅隆大学的Mayhem机器CTF战队与另外14支人类顶尖CTF战队同台较量,并一度超过2支人类战队排名第13。自动化攻击系统能站上Defcon CTF赛场,开创了“机器智能”和“自动化攻防”的新局面。由此可见,人工智能在赋能攻击的方面还是很强大的。

人工智能所伴生的安全问题

人工智能自身存在着脆弱性,例如对抗样本就是人工智能的内生安全问题。对抗样本是机器学习模型的一个有趣现象,反映出了人工智能算法的弱点。攻击者通过在源数据上增加人类难以通过感官辨识到的细微改变,但是却可以让机器学习模型接受并做出错误的分类决定。一个典型的场景就是图像分类模型的对抗样本,通过在图片上叠加精心构造的变化量,在肉眼难以察觉的情况下,让分类模型产生误判。对抗样本除在图像识别领域存在,也在其他领域存在,如语音、文本等。从网络安全领域看,同样存在类似于对抗样本的攻击问题,攻击者通过对恶意代码插入扰动操作就有可能对人工智能模型产生欺骗。例如,有人就设计了一个恶意样本,让分类器将一个存有恶意行为的软件认定为良性的变体,从而可以构造能自动逃逸PDF恶意软件分类器的攻击方法,以此来对抗机器学习在安全中的应用。上述安全问题都可能会导致同样后果,就是导致人工智能系统发生错误的决策、判断,以及系统被控制等问题。

人工智能技术存在着巨大的安全性挑战。目前人工智能系统还无法超出固有的场景或对特定语境的理解,人工智能技术在下棋或游戏等有固定规则的范围内一般不会暴露其脆弱性,当环境数据与智能系统训练的环境大相径庭,或者实际的应用场景发生变化,或者这种变化超出机器可理解的范围时,人工智能系统可能就立刻失去判 断能力。美国智库“新美国安全中心”最近发布的《人工智能:每个决策者需要知道什么》报告显示,人工智能的一些弱点可能对国家安全等领域造成巨大影响。

人工智能的失误可能会给人类带来灾难,从而会形成衍生安全问题。2016年5月7日,在佛罗里达州公路上一辆处于“自动驾驶”模式的特斯拉Model S以74英里的时速,撞上了拐弯中的白色拖挂式大货车。Model S从货车车底穿过,车顶被完全掀飞,40岁的驾驶员Joshua Brown不幸死亡。出事路段限制时速为65英里/时。由于 “自动驾驶”模式车前的高清摄像头为长焦镜头,当白色拖挂卡车进入视觉区域内时,摄像头只能看到悬浮在地面上的卡车中部,而无法看见整个车辆;此外,当时阳光强烈(蓝天白云),使得自动驾驶系统无法识别出障碍物是一辆卡车,而更像是飘在天上的云,导致自动刹车未生效。这次事故引发了外界对自动驾驶汽车安全性的争议。这种自动驾驶的缺陷导致人类伤亡的事情,是典型的人工智能衍生安全的案例。

当前,人们已经开始关注人工智能自身的安全问题,霍金曾经在2015年8月与美国Reddit 网的问答互动中,提出了人工智能“威胁论”的观点,后又曾多次在世界知名期刊撰文强调类似看法。比尔•盖茨称,人类在人工智能领域已经取得了很大进展,这些进展能让机器人在接下来的10年内学会驾驶和做家务,在一些特定的领域甚至能比人类优秀。但是之前他曾经提出警告,“人工智能如果进展太快,可能会对未来的人类造成一定威胁”。特斯拉创始人马斯克在Code大会上也预测智能机器人未来,他认为未来人类生活将离不开虚拟现实技术,而这一技术的高度发展将使人类很难分辨出真实与游戏的区别;加之人工智能的飞速发展,人类智商将会止步不前;最为严重的后果是机器人反超人类成为实际运营世界的主体,人类在机器人心中可能如宠物一般的存在。

防止人工智能体行为失控的方案

随着人工智能技术的高速发展,人工智能行为体越来越有可能在不远的将来成为人类生活重要组成部分。目前,相关研究领域专家已认识到人工智能存在巨大风险,并从人工智能安全设计原则、标准规范、道德伦理方面进行呼吁。但是,针对如何设计一个防止具有行为能力的人工智能系统失控的装置?该装置应具备的什么样的控制功能和性能指标?该装置的软硬件形态是什么?这些目前尚无研究成果。

人工智能为什么会危害人类?前提是要有一个具有行为能力的、由人工智能来操作的行为体。人工智能行为体是指一类能感知外部环境并将之作为输入,通过内部算法进行决策,并利用自身驱动装置与物理世界产生交互行为的自主硬件实体。自动行走机器人、自动驾驶汽车和人工智能武器等,都是人工智能行为体的类型。人工智能行为体需要有感知外部环境、内部控制逻辑、运动驱动装置和自主能力(自学习)四个要素的体现。外部环境包括所处的自然环境和相关生物体等;内部控制逻辑是指预制在人工智能行为体内部,用于产生运动行为的程序;运动驱动装置是可与物理世界交互,或者可改变人工智能行为体处所空间坐标的硬件;自主能力是指人工智能行为体可以自己设定要达到的目标函数或自主决策,而非由人类设定目标。

人工智能在什么情况下会危害人类?需要同时满足三个条件,第一,有行为能力,AlphaGo是下棋机器人,不能动,所以不会危害人类;第二,有足够破坏力的动能,有危害性,扫地机器人不具有破坏的动能,所以不会危害人类;第三,具有自主能力,完全听命于人类的系统,不会主动伤害人类,但会误伤人类。

首先,能动的问题已解决;第二,有破坏力的机器人也已经存在,这是一个危险因素;第三个要素,自主行为体。运动体已经比比皆是,破坏力已经突破掉了,关键就是能不能自主。但是我们不能太相信机器人不会自我进化到具有危害人类的程度,所以对它预先要有约束。针对机器人来说有一个国际标准,提出了四种约束条件。第一是安全级的监控停止,当出现问题时,有让它停止的能力;第二是手动引导,做什么事情让它做它才开始做,如果这个机器人只能手动才开始做,它就没办法给自己设定攻击性目标;第三是速度和距离监控,当它和人比较接近时,速度必须降下来;第四是功率和力的限制,当和人接近时其功率必须迅速降下来。这些都是保护人类要做的事情。

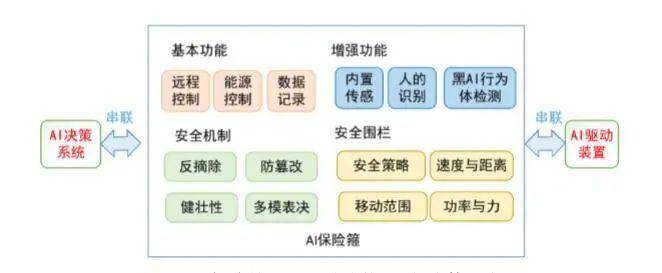

我们提出一种如图1所示的防止人工智能行为体失控的方法——AI保险箍。图中,串联模块用于与人工智能行为体的决策系统和驱动装置连接;反摘除模块用于在发生暴力拆除时,毁灭人工智能行为体,其确保本装置无法从人工智能行为体总摘除。AI保险箍方法的核心要点包括:①人工智能行为体的驱动装置需采取主动探测或被动监听等方法,以检测到一个授权的、认证的、可信的控制系统(AI保险箍)的存在,并接受其完全控制;② 当人工智能行为体无法检测到一个授权的、认证的、可信的控制系统存在时,应停止一切工作;③ 速度与距离监控,当人工智能行为体中某个危险部件与人之间的距离小于安全距离时,触发保护停止、触发与人工智能行为体相连的安全级功能;④ 在人工智能行为体发生失控时,系统能根据远程控制命令,实现人工智能行为体的远程控制,使其无法危害人类或将危害控制到最低;⑤ 系统会对人工智能行为体进行风险识别,当识别出风险时,发出警报示警,进一步防止人工智能行为体因为失控而造成的损害。

图 1 AI 保险箍——一种防控 AI 行为体的方法

结束语

人工智能作为最具颠覆性和战略性的核心关键技术,持续引起全球产业界、学术界和各国政府的高度关注。当前,人工智能技术在安全领域的应用需求日益迫切,同时,人工智能自身的安全问题也不容小觑,安全与人工智能并举,双方的融合发展与创新是我强国战略中不可忽视的重要助推因素。

选自《中国人工智能学会通讯》

2020年 第10卷 第4期 人工智能与安全专题

方滨兴

中国工程院院士,中国电子信息产业集团(CEC)首席科学家, 中国中文信息学会、中国网络空间安全人才教育联盟和中国网络空间新技术安全创新联盟理事长,广州大学网络空间先进技术研究院名誉院长,哈尔滨工业大学(深州)计算机学院首席顾问,信息内容安全技术国家工程实验室主任,可信分布式计算与服务教育部重点实验室主任。

AI 研习 往期文章

洪宇:信息抽取的常识与前沿

专题:不完全信息计算机博弈的模型与应用

专题:藏族久棋计算机博弈研究

专题:随机性博弈估值函数及其搜索策略研究

专题:爱恩斯坦棋中概率启发的并行蒙特卡洛树搜索算法

专题:一种军棋计算机博弈的多棋子协同博弈方法

优秀博士学位论文精华版:面向互联网金融微观对象的数据挖掘方法及应用研究优秀博士学位论文精华版:零和博弈的事件驱动自适应动态规划方法优秀博士学位论文精华版:基于深度学习的自然场景文字检测与识别方法研究优秀博士学位论文精华版:时滞递归神经网络稳定性与同步控制优秀博士学位论文精华版:大规模图像检索方法研究

专题:基于人机协同决策的印染废水处理智能管控技术研究

专题:活性污泥法污水处理过程自动控制研究综述专题:城市污水处理过程协同优化控制专题:城市污水处理过程智能自组织控制方法研究与应用专题:自适应多输出高斯过程模型于城市污水的应用与实践汪培庄:因素空间与人工智能何晓冬:语言与视觉的跨模态智能黄铁军:视达2020——翻开视觉新篇章宗成庆:人类语言技术展望

点击左下角“阅读原文”,加入CAAI

来源:CAAI-1981 中国人工智能学会

原文链接:https://mp.weixin.qq.com/s?__biz=MjM5ODIwNjEzNQ==&mid=2649802248&idx=1&sn=ab6d40f2a80154b4a6e0c50b8c81b21a&chksm=beca29d089bda0c6fd25a42d9c84153b35eb75710505241b950ba2ad6c2bcd9e7cd44409a7bb#rd

版权声明:除非特别注明,本站所载内容来源于互联网、微信公众号等公开渠道,不代表本站观点,仅供参考、交流、公益传播之目的。转载的稿件版权归原作者或机构所有,如有侵权,请联系删除。

电话:(010)86409582

邮箱:kejie@scimall.org.cn